こんにちは!!ようこそ、当ブログgcbgardenへ。管理人のsakurabaaa(@sakurabaaa_g)です。

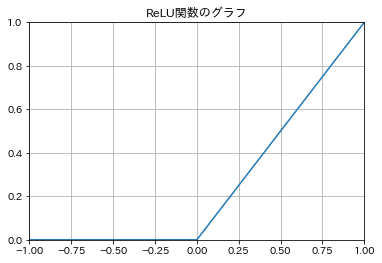

機械学習の手法であるロジスティック回帰やニューラルネットワークでよく使われるReLU関数をPython、numpy、matplotlibを用いて記述したコードと、出力結果(グラフ)をまとめています。

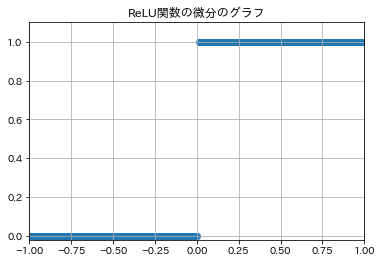

ReLU関数の微分もコードと合わせて紹介します。

※本プログラムは、数値計算ライブラリNumpyや描画ライブラリmatplotlibを使いJupyter Notebookでコードを実行しています。いますぐコードを実行し、結果をみてみたい方は「Jupyter Notebook」にアクセスし、「Try it in your browser」で実践してみてください。

PythonでReLU関数

ReLU関数は次式です。

$$\begin{equation}

f(x) =

\begin{cases}

x\hspace{10mm}x>0 \\

0\hspace{10mm}x≦0

\end{cases}

\end{equation}$$

入力値が負であれば0を、入力値が正であれば入力値を出力します。

ReLU関数 コード

ReLU関数 グラフ

PythonでReLU関数の微分

ReLU関数の微分は次式です。

$$\begin{equation}

f'(x) =

\begin{cases}

1\hspace{10mm}x>0 \\

0\hspace{10mm}x≦0

\end{cases}

\end{equation}$$

入力値が負であれば0を、入力値が正であれば1を出力します。

ReLU関数の微分 コード

ReLU関数の微分 グラフ

まとめ

ReLU関数はニューラルネットワークの活性化関数でよく使われています。

ソースコードはコピペで利用できるので実際に出力させてみてください!!

もっとくわしく勉強したい方には、以下のページがおすすめです。

この記事を書いた人。

20代。とあるネットベンチャーでがんばる働き屋さん、ブロガー。

書きたいことを気ままに書いてます!

Python、プログラミング、米株、カメラ、野球観戦がすき。趣味は新宿散策。